ابتدا قبل از هر چیزی اگر اکانت در گوگل ندارید یکی بسازید.

وارد صفحۀ وبمستر تولز گوگل بشوید و طبق دستورات زیر عمل کنید:

پس از ورود به این سرویس بر روی دکمه ...Add a site کلیک کنید در نوار کشوی که باز می شود آدرس وب سایت خورد را به صورت http://www.yoursite.com وارد کنید . و سپس دکمه Continue را جهت ثبت وب سایت کلیک کنید.

حال آدرس سایت نمایش داده خواهد شد که نیاز به تایید دارد. برای تایید سایت بر روی گزینه Verify this site کلیک کنید تا وارد صفحه Verify ownership شوید در قسمت Verification method سه روش را در اختیار شما قرار میدهد تا به صورت دلخواه انتخاب کنید.

روش اول اضافه کردن کد html به کدهای html سایت است مانند توضیحاتی که در بخش Show me an example آمده است.

روش دوم اضافه کردن فایل html در روت وب سایت است ابتدا آن صفحه را دانلود میکنید و سپس در روت وب سایت آپلود میکنید. پس از آپلود باید بتوانید نشانی کامل فایل را که پس از آدرس دامنه تان می آید ببینید. (مثال: http://example.com/uvrjvrbrtbtsz2540ne524b242w5b4h523n4)

روش سوم اضافه کردن کد به dns وب سایت است که البته دو روش اول ساده تر و کاربردی هستند.

بعد انجام هریک از این روشها بر روی Verify کلیک کنید تا در صورت انجام درست مراحل وب سایت تائیید گردد.

ورود بخش مدیریت یک وب سایت

بر روی نام وب سایت مورد نظر که از قبل ثبت گریده کلیک کنید تا وارد بخش مدیریت آن شود.

در این صفحه اطلاعات کلی از آخرین وضعیت سایت نمایش داده می شود.این اطلاعاتی در مورد وضعیت sitemap ها، وضعیت بازبینی سایت توسط موتور گوگل و وضعیت کلمات کلیدی جستجو شده برای ورود به سایتتان است.

در منوی سمت چپ صفحه لیست کشوی می بینید که به وسیله آن به سایر قسمت های مدیریت دسترسی پیدا خواهید کرد.

توضیحات منوی تنظیمات سایت Site configuration

مدیریت Sitemap

یا نقشه وب سایت، شما وقتی یک صفحه را در وب سایت خود می سازید می توانید با چند استاندارد آدرس این صفحات را به گوگل و سایر موتورهای جستجوگر معرفی کنید به مجموعه ای از این آدرس های که در قالبی خاص تعریف میگردند نقشه سایت یا سایت مپ میگویند.

گوگل این امکان را می هد که نقشه سایت را به صورت استاندارد Feed "خوراک" و XML ثبت کنید.

ثبت نقشه سایت در گوگل می تواند خیلی سریع تر صفحات وب سایت شما را در گوگل ذخیره کند و به دیگران این امکان را می دهد، آدرسهایی که ممکن است لینکی به آنها داده نشده باشه را پیدا کنند. همچنین تغییرات صفحات را خیلی سریعتر شناسایی خواهد کرد. استفاده از این سرویس خیلی موثر است پس از ثبت نقشه سایت می توانید در قسمت SITEMAP STATS مجموع صفحات وب سایت شما و میزان صفحات ذخیره شده در گوگل را نمایش می دهد.

مدیریت دسترسی خزنده به قسمتهای سایت (Crawler access)

برای جلوگیری از دیده شدن قسمت های از وب سایت مانند فولدرها و صفحات به دلایلی مانند جلوگیری از هک شدن وب سایت و همینطور عدم افشای بعضی از مطالب می توان از فایلی به نام robots.txt استفاده کرد که این فایل فرمت خاصی دارد که این امکان را می دهد که ربات های موتورهای جستجوگر را مدیریت کرد که به کدامیک از صفحات و فولدرها دسترسی داشته باشند.

تمام موتور جستجو گر از این فایل پشتیبانی می کنند گوگل در این بخش این اجازه را می دهد که کنترل بیشتری بر روی دسترسی ها داشته باشید. امکان حذف آدرسها در تب Remove URL یکی از این موارد است همچنین در تب Generate robots.txt به تولید فایل robots.txt پرداخت و آن را در موتور های جستجوی مختلف گوگل مورد آزمایش قرار داد.

مدیریت SiteLinks

در صورتی که معماری سایت به درستی پیاده سازی شده باشد و دارای بازدیدکننده بالا و همچنین PageRank بالایی باشد در این صورت ممکن است که گوگل لینک ها یا به عبارتی منوهای وب سایت شما را به صورت خاص و تفکیک شده نمایش دهد که این امتیازی بسیار عالی از سوی گوگل به وب سایت شما میباشد.

تنظیمات تغیر آدرس وب سایت Change of address

اگر قصد تغییر آدرس دامنه وبسایتتان را دارید از این قسمت میتوانید برای مطلع کردن گوگل از این تغییر استفاده کنید تا با سرعت بیشتری صفحات جدید وب سایت شما را ذخیره کند.

تنظیمات کلی (Settings)

در صفحه تنظیمات اولین مورد Geographic target است که در این قسمت می توانید موقعیت جغرافیایی یا کشور هدف را انتخاب کنید. با این انتخاب سایت شما فقط در جستجو هایی که از آن کشور انجام می شود قرار خواهد گرفت.

مورد دوم Preferred domain است که می توانید به گوگل بگویید آدرس سایت شما را با www نمایش بدهد یا نه و یا اینکه با توجه به لینک ها این کار را انجام دهد.

مورد سوم تنظیم تعداد دفعات مراجعه خرنده گوگل به وب سایت در قسمت Crawl rate است. ممکن است که به علت بزرگ بودن سایت و مشکلات سرور نتوانید پاسخ گوی درخواستهای اضافی باشید که در این صورت این مقدار باید کم شود و در صورتی که از عدم شناسایی به موقع تغییرات وب سایت ناراضی هستید مقدار آن را افزایش دهید.

توضیحات منوی Your site on the web

کلمات کلیدی در جستجو نمایش داده شده search queries

در این قسمت کلمات کلیدی که در موتور جستجوگر موجب مراجعه به سایت شما شده است به همراه موقعیت آن کلمات کلیدی از وب سایت شما در صفحات گوگل نمایش داده می شود. علاوه بر آن میزان کلیک ها و CTR ها را هم نمایش میدهد.گر کلمه کلیدی از وب سایت شما خیلی مهم واقع شود و آمار بازدید زیادی داشته باشد ستاره دار خواهد شد.

با استفاده از این کلمات می توان نیاز کاربران را به درستی درک کرد و از این کلمات برای بهینه تر کردن وب سایت خود بهره ببرید و در صورت استفاده از تبلیغات کلیکی گوگل هدفمندتر به امر تبلیغات بپردازید.

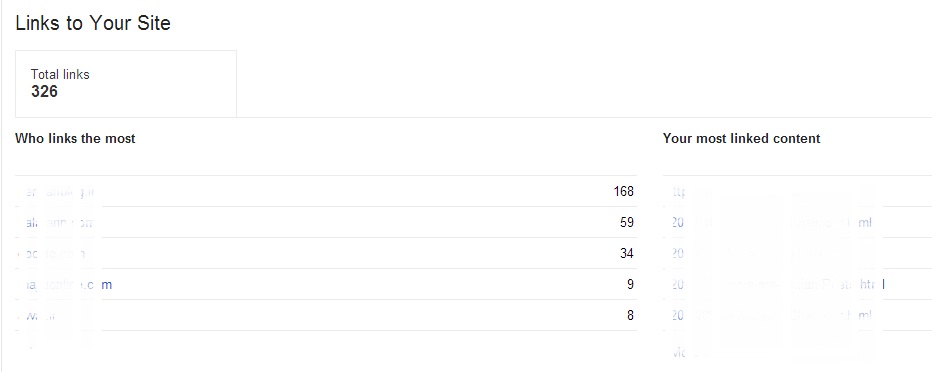

لینک ها به سایت شما Links to your site

در این قسمت آدرس صفحاتی از وب سایت شما را که لینکهایی ارزشمند از سایت های دیگر به آن داده شده است لیست شده و نمایش داده میشود شما می توانید می توان متن لینکی که برای لینک دادن استفاده شده است و آدرس وب سایت های لینک دهنده را مشاهده کرد.

از ویژگی برای بهینه کردن وب سایت و لینک های خارجی میتوان استفاده کرد.

لینک های داخلی Internal Links

لیست صفحاتی که در داخل سایت به یکدیگر لینک داده شده اند به همراه تعداد لینکها و صفحات لینک داده شده وجود دارد.

توضیحات منوی امکانات عیب شناسی Diagnostics

خطاهای خزنده Crawl errors

در این قسمت خزنده یا همان ربات گوگل وقتی وارد سایت شما می شود تا اطلاعات آن را ارزیابی کند و با خود ببرد خطاهایی که در این هنگام کنکاش درون سایت مواجه می شود را نمایش میدهد. این خطاها به چهار دسته Web ،Mobile-Chtml ،Mobile-Xhtml تقسیم بندی گردیده است. اگر مشکلی در صفحات وب سایت شما رخ دهد گزارش کاملی در این قسمت در اختیار شماست و این گزارشات را جدی بگیرید ! چون حساسیت گوگل به این خطاها بالاست.

در قسمت "Restricted by robots.txt" لیست صفحاتی که توسط robot.txt پاک گردیده اند را نمایش میدهد.

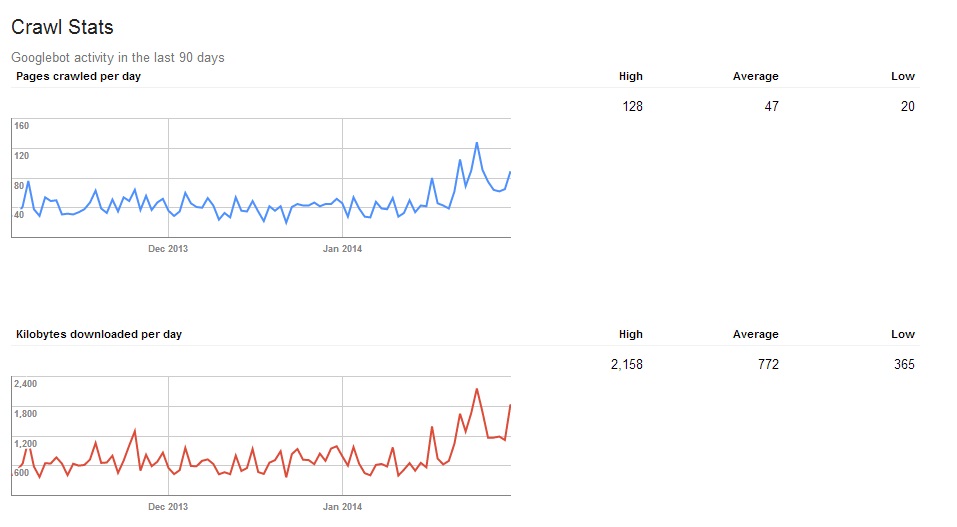

گزارش وضعیت خزنده Crawl stats

در این صفحه شما گزارشی از وضعیت صفحات کنکاش شده توسط خزنده یا همان ربات موتور جستجوگر بر روی سایت را دارید که شامل صفحات کنکاش شده درهرروز ،میانگین مدت زمان صرف شده برای دریافت صفحات ، کیلوبایت صفحات دانلود شده در هر روز است.

پیشنهادهای کدهای اچ تی ام ال HTML suggestions

در این قسمت هنگامی خزنده سایت به سایت شما مراجعه میکند اگر مسئله ی را با محتوایی صفحات سایت شما بیابد به صورت لیست از صفحات که دارای مشکل هستند را ارائه میدهد که حل این ریز مشکلات موجود در صفحات کمک بسزای در ذخیره کردن صفحات شما در موتور جستجوگر خواهد نمود.

این بخش شامل سه قسمت است که هر قسمت خود شامل سه مورد Duplicate meta , Long meta , Short meta است:

قسمت اول Meta description می باشد که اگر توضیحاتی تکراری در صفحات وب سایت داشته باشید در Duplicate meta description نمایش داده خواهد شد و اگر توضیحات صفحاتان بلندتر از حد مجاز باشد در Long meta descriptions نمایش داده خواهد شد که باید کوتاه تر گردند و اگر توضیحات صفحاتتان کوتاه باشد در Short meta descriptions نمایش داده خواهد شد که باید بلندتر گردند.

سایر قسمت ها نیز به همین صورت میباشند.